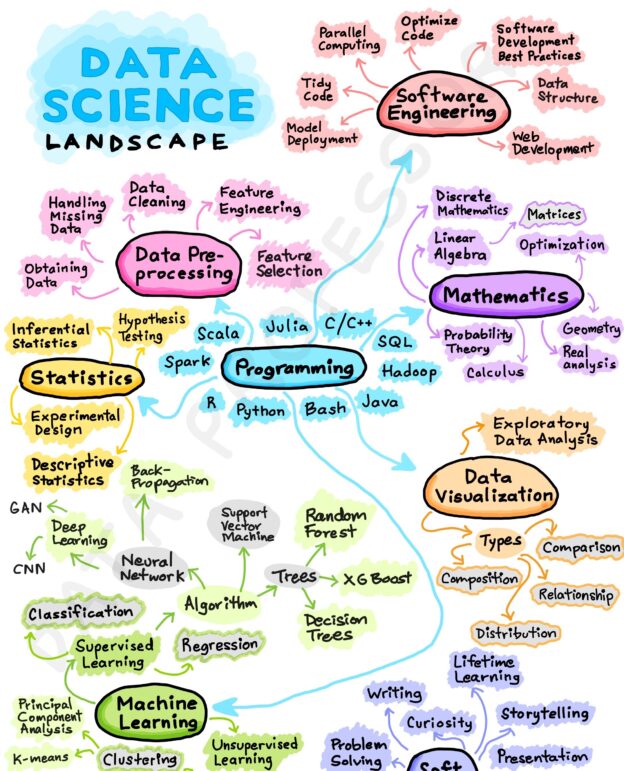

Como Data Analyst, contar con las herramientas adecuadas es esencial para tener éxito en esta disciplina. En este artículo, exploraremos las 10 herramientas más importantes que todo Data Analyst debe dominar. Desde lenguajes de programación como Python y R, hasta herramientas de visualización como Tableau y Power BI, descubrirás cómo estas herramientas pueden potenciar tu capacidad para extraer información valiosa de los datos y tomar decisiones informadas. Prepárate para embarcarte en un viaje fascinante a través del análisis de datos y desbloquear el poder de estas herramientas indispensables.

Python

Hay varias razones por las que aprender Python es fundamental para los Data Analysts. Aquí tienes algunas de ellas:

Amplia adopción en la industria: Python se ha convertido en uno de los lenguajes de programación más populares en el ámbito del análisis de datos. Es ampliamente utilizado por profesionales y organizaciones en diferentes sectores. Aprender Python te permitirá adaptarte rápidamente a las necesidades y demandas del mercado laboral en este campo.

Sintaxis clara y legible: Python se destaca por su sintaxis clara y legible, lo que facilita la escritura y comprensión del código. Esto hace que sea más fácil para los Data Analysts trabajar con grandes conjuntos de datos y desarrollar soluciones eficientes.

Gran cantidad de bibliotecas especializadas: Python cuenta con una amplia gama de bibliotecas especializadas en análisis de datos, como Pandas, NumPy, Matplotlib, scikit-learn y muchos más. Estas bibliotecas proporcionan funcionalidades avanzadas para manipulación, limpieza, visualización y modelado de datos, lo que acelera el proceso de análisis y permite realizar tareas complejas de manera más eficiente.

Integración con otras tecnologías: Python se integra fácilmente con otras tecnologías y herramientas utilizadas en el análisis de datos. Puedes trabajar con bases de datos, utilizar herramientas de big data como Apache Spark, conectarte a APIs y servicios web, y mucho más. Esto te permite ampliar tus habilidades y aprovechar diversas herramientas en tu trabajo como Data Analyst.

Comunidad activa y soporte: Python cuenta con una comunidad activa y comprometida de desarrolladores y usuarios. Hay una gran cantidad de recursos, tutoriales, documentación y foros disponibles para ayudarte a resolver problemas y ampliar tus conocimientos. Además, la comunidad contribuye constantemente con nuevas bibliotecas y actualizaciones, lo que asegura que Python esté siempre actualizado y en constante evolución.

Flexibilidad y escalabilidad: Python es un lenguaje flexible y escalable que se adapta a diferentes proyectos y requisitos. Puedes utilizarlo para tareas sencillas de análisis de datos, así como para proyectos más complejos que involucren machine learning, big data y desarrollo de aplicaciones. Esto te brinda la libertad de abordar una amplia gama de desafíos y proyectos en tu carrera como Data Analyst.

SQL

Aprender SQL (Structured Query Language) es fundamental para los Data Analysts por las siguientes razones:

Gestión y extracción de datos: SQL es el lenguaje estándar para interactuar con bases de datos relacionales. Como Data Analyst, es esencial comprender cómo acceder y extraer datos de manera eficiente para realizar análisis. SQL te permite escribir consultas para seleccionar, filtrar y combinar datos de diferentes tablas, lo que facilita la gestión de grandes conjuntos de datos.

Análisis exploratorio de datos: SQL te permite realizar análisis exploratorio de datos de manera rápida y efectiva. Puedes utilizar funciones agregadas, como SUM, COUNT, AVG, para obtener información resumida sobre los datos. También puedes aplicar cláusulas de filtrado, como WHERE y HAVING, para extraer subconjuntos de datos específicos y realizar análisis más detallados.

Manipulación y transformación de datos: SQL te permite manipular y transformar datos dentro de una base de datos. Puedes utilizar instrucciones como UPDATE, INSERT y DELETE para modificar los datos existentes o agregar nuevos registros. También puedes utilizar sentencias de JOIN para combinar datos de múltiples tablas y realizar cálculos complejos.

Creación de informes y dashboards: SQL es esencial para la creación de informes y dashboards basados en datos. Puedes utilizar consultas SQL para extraer los datos necesarios y luego utilizar herramientas de visualización como Tableau o Power BI para presentar los resultados de manera visualmente atractiva y fácil de entender.

Optimización de consultas: A medida que trabajas con bases de datos más grandes y complejas, la optimización de consultas se vuelve importante para mejorar el rendimiento y la eficiencia. Aprender SQL te permite comprender los conceptos de índices, claves primarias, claves foráneas y otras técnicas de optimización para acelerar tus consultas y mejorar la eficiencia en el acceso a los datos.

Integración con otras herramientas y lenguajes: SQL se integra con una amplia gama de herramientas y lenguajes utilizados en el análisis de datos. Puedes utilizar SQL en combinación con Python, R u otras herramientas de análisis para realizar tareas más complejas, como el modelado estadístico, el análisis predictivo o el aprendizaje automático.

Tableau

Aprender Tableau es altamente beneficioso para los Data Analysts por las siguientes razones:

Visualización de datos interactiva: Tableau es una herramienta poderosa para crear visualizaciones interactivas y atractivas. Permite generar gráficos, diagramas, tablas y paneles interactivos que facilitan la comprensión y comunicación de los datos. Como Data Analyst, podrás crear visualizaciones dinámicas y explorar los datos de manera interactiva para descubrir patrones, tendencias y relaciones ocultas.

Análisis rápido y exploratorio: Tableau proporciona una interfaz intuitiva y fácil de usar, lo que te permite realizar análisis de datos de manera rápida y ágil. Puedes arrastrar y soltar variables, aplicar filtros y realizar cálculos rápidos sin necesidad de escribir código. Esto agiliza el proceso de exploración de datos y te permite obtener información relevante de manera eficiente.

Integración con múltiples fuentes de datos: Tableau permite conectar y combinar datos de múltiples fuentes, como bases de datos, archivos CSV, hojas de cálculo de Excel, servicios web, entre otros. Esto te brinda la flexibilidad para trabajar con diferentes tipos de datos y aprovechar la información de diversas fuentes en tus análisis.

Compartir y colaborar: Tableau permite compartir tus análisis y visualizaciones con otros usuarios de manera sencilla. Puedes publicar tus dashboards en línea y compartirlos con colegas o stakeholders. Además, Tableau ofrece opciones de colaboración, lo que facilita el trabajo en equipo y la revisión conjunta de los análisis.

Análisis avanzado y estadístico: Tableau ofrece capacidades avanzadas de análisis y estadísticas. Puedes realizar cálculos complejos, aplicar modelos estadísticos, realizar análisis de series temporales y realizar pronósticos utilizando las funciones incorporadas de Tableau. Esto te permite llevar tus análisis más allá de las visualizaciones básicas y profundizar en el descubrimiento de información valiosa.

Power BI

Aprender Power BI es altamente beneficioso para los Data Analysts por las siguientes razones:

Integración con múltiples fuentes de datos: Power BI permite conectar y combinar datos de diversas fuentes, como bases de datos, archivos CSV, hojas de cálculo de Excel, servicios en la nube y muchas más. Esto te brinda la flexibilidad para trabajar con diferentes tipos de datos y aprovechar la información de múltiples fuentes en tus análisis.

Visualización de datos interactiva: Power BI ofrece una amplia gama de opciones de visualización de datos, desde gráficos simples hasta tablas dinámicas y mapas interactivos. Puedes crear visualizaciones atractivas y personalizadas para comunicar tus hallazgos de manera efectiva. Además, Power BI permite la exploración interactiva de datos, lo que significa que los usuarios pueden filtrar y profundizar en los datos para obtener información más detallada.

Creación de informes y dashboards: Permite crear informes y paneles interactivos que resumen tus análisis de datos. Puedes diseñar paneles personalizados con visualizaciones, tablas y gráficos que proporcionen una visión general clara de los datos. Además, Power BI ofrece opciones de formato y diseño para mejorar la apariencia y la estética de tus informes.

Análisis de datos avanzado: Tiene capacidades avanzadas de análisis y modelado de datos. Puedes realizar cálculos complejos utilizando fórmulas DAX (Data Analysis Expressions) para crear medidas personalizadas y KPIs. Además, Power BI permite realizar análisis de tendencias, segmentación de datos, filtrado avanzado y muchas otras técnicas de análisis para descubrir patrones y relaciones ocultas en los datos.

Integración con Microsoft Office y Azure: Power BI se integra estrechamente con otras herramientas y servicios de Microsoft, como Excel, SharePoint y Azure. Esto facilita el intercambio de datos y la colaboración con otros usuarios. Además, Power BI permite la implementación y el acceso a los informes y dashboards en la nube a través de Azure, lo que brinda una mayor escalabilidad y disponibilidad.

Compartir y colaborar: Esta herramienta permite compartir tus informes y dashboards con colegas y stakeholders de manera fácil y segura. Puedes publicar tus informes en línea y compartirlos a través de enlaces, correos electrónicos o integraciones con otras plataformas. Además, Power BI ofrece opciones de colaboración que permiten a varios usuarios trabajar en el mismo informe de manera simultánea y realizar revisiones conjuntas.

Apache Spark

Aprender Apache Spark es altamente beneficioso para los Data Analysts por las siguientes razones:

Procesamiento de grandes volúmenes de datos: Apache Spark es una herramienta diseñada específicamente para el procesamiento de grandes volúmenes de datos a escala. Permite procesar y analizar conjuntos de datos masivos de manera eficiente y distribuida, lo que acelera los tiempos de respuesta y facilita el análisis de grandes cantidades de información.

Velocidad y rendimiento: Spark utiliza una arquitectura en memoria que permite realizar operaciones de procesamiento de datos de manera significativamente más rápida que otras herramientas tradicionales. Además, aprovecha el procesamiento paralelo y la capacidad de procesamiento distribuido para obtener un rendimiento óptimo en tareas intensivas en datos.

Soporte para múltiples fuentes de datos: Apache Spark es compatible con una amplia variedad de fuentes de datos, incluyendo sistemas de almacenamiento distribuido, bases de datos relacionales, archivos en diferentes formatos (como CSV, JSON, Parquet, Avro, entre otros) e incluso datos en tiempo real a través de la integración con sistemas de streaming.

Conjunto de herramientas y bibliotecas: Spark ofrece un conjunto completo de herramientas y bibliotecas que facilitan el procesamiento, análisis y manipulación de datos. Por ejemplo, Spark SQL permite trabajar con datos estructurados utilizando SQL y DataFrame API. Spark Streaming permite procesar y analizar datos en tiempo real. Spark MLlib proporciona algoritmos de aprendizaje automático y Spark GraphX se utiliza para análisis de grafos.

Integración con otros frameworks y herramientas: Apache Spark se integra con otras herramientas y frameworks populares en el ecosistema de Big Data, como Hadoop, Hive, HBase, Kafka, entre otros. Esto permite aprovechar las ventajas de estas tecnologías y crear soluciones más completas y escalables para el análisis de datos.

Escalabilidad y tolerancia a fallos: Spark ofrece una arquitectura distribuida que permite escalar horizontalmente el procesamiento de datos según las necesidades. Además, proporciona mecanismos de tolerancia a fallos que garantizan la confiabilidad y disponibilidad de los datos y las aplicaciones incluso en entornos distribuidos.

SAS

Aprender SAS (Statistical Analysis System) es beneficioso para los Data Analysts por las siguientes razones:

Amplia funcionalidad estadística: SAS es conocido por su amplia gama de técnicas y herramientas estadísticas. Ofrece una amplia funcionalidad para realizar análisis estadísticos, desde análisis descriptivos básicos hasta técnicas más avanzadas como regresión, análisis de supervivencia, análisis factorial y más. Con SAS, los Data Analysts pueden realizar análisis estadísticos rigurosos y obtener información precisa y confiable.

Gestión y manipulación de datos: SAS proporciona una amplia gama de funciones y procedimientos para la gestión y manipulación de datos. Permite importar, limpiar, transformar y combinar conjuntos de datos de manera eficiente. SAS también ofrece capacidades de manipulación de datos avanzadas, como la creación de variables calculadas, la recodificación de variables y la generación de muestras aleatorias.

Integración con otras herramientas y lenguajes: SAS se integra con otras herramientas y lenguajes utilizados en el análisis de datos. Puedes combinar SAS con Python, R y SQL para aprovechar las fortalezas de cada lenguaje y ampliar tus capacidades analíticas. Esto te permite utilizar las funcionalidades específicas de SAS junto con otras herramientas y bibliotecas populares en el campo del análisis de datos.

Análisis y modelado predictivo: SAS es conocido por su capacidad de realizar análisis y modelado predictivo. Proporciona una variedad de técnicas de aprendizaje automático y minería de datos que te permiten construir modelos predictivos avanzados. Puedes realizar análisis de segmentación, clasificación, regresión y detección de anomalías utilizando las herramientas y algoritmos disponibles en SAS.

Generación de informes y visualización de datos: Tiene opciones flexibles para la generación de informes y la visualización de datos. Puedes crear informes personalizados con tablas, gráficos y visualizaciones interactivas utilizando la interfaz de programación de SAS. También puedes utilizar otras herramientas de visualización, como SAS Visual Analytics, para crear paneles interactivos y visualizaciones dinámicas.

Hadoop

Aprender Hadoop como Data Analyst es beneficioso por las siguientes razones:

Procesamiento y almacenamiento escalable: Hadoop es una plataforma diseñada para el procesamiento y almacenamiento de grandes volúmenes de datos a escala. Como Data Analyst, aprender Hadoop te permite aprovechar su arquitectura distribuida y su capacidad para procesar y almacenar datos de manera escalable. Puedes trabajar con conjuntos de datos masivos sin preocuparte por los límites de capacidad y rendimiento.

Manejo de datos no estructurados: Hadoop es especialmente adecuado para trabajar con datos no estructurados, como texto, imágenes, archivos de registro, datos de sensores, etc. Como Data Analyst, aprender Hadoop te permite aprovechar su capacidad para procesar y analizar diferentes tipos de datos y extraer información valiosa de ellos.

Frameworks de procesamiento: Hadoop proporciona frameworks de procesamiento como MapReduce y Apache Spark, que te permiten realizar cálculos distribuidos en conjuntos de datos masivos. Estas herramientas te permiten realizar análisis complejos, procesar datos en paralelo y obtener resultados más rápidos y eficientes.

Análisis y extracción de información: Con Hadoop, puedes aprovechar herramientas de análisis y extracción de información, como Apache Hive y Apache Pig. Estos frameworks te permiten consultar y analizar datos almacenados en Hadoop utilizando lenguajes de consulta y scripting similares a SQL. Esto te brinda la capacidad de realizar análisis avanzados en conjuntos de datos masivos y extraer información valiosa para la toma de decisiones.

Integración con el ecosistema de Big Data: Hadoop se integra con una amplia gama de herramientas y tecnologías del ecosistema de Big Data. Puedes combinar Hadoop con otras herramientas como Apache Kafka, Apache HBase, Apache Cassandra y más, para crear soluciones de análisis de datos más completas y escalables.

Habilidades Blandas

Además de las habilidades técnicas necesarias para ser un Data Analyst exitoso, también es importante desarrollar habilidades blandas o habilidades sociales que complementen tu perfil profesional. Estas habilidades te permitirán trabajar de manera efectiva en equipo, comunicarte de manera clara y tener un enfoque orientado al cliente. Algunas habilidades blandas importantes para un Data Analyst son:

Pensamiento analítico

Resolución de problemas

Comunicación efectiva

Colaboración y trabajo en equipo

Orientación al cliente

Adaptabilidad y aprendizaje continuo

Ética y responsabilidad