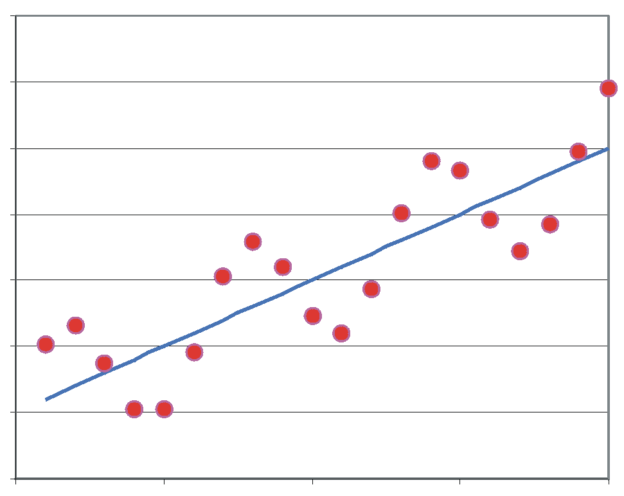

La multicolinealidad es una situación en la que dos o más variables predictoras en un modelo de regresión están altamente correlacionadas entre sí. Esto puede ser un problema para el modelo, ya que hace que sea difícil determinar el efecto individual de cada variable en la variable de respuesta, y puede conducir a resultados inestables o incoherentes.

La multicolinealidad puede ocurrir cuando las variables predictoras están relacionadas entre sí o cuando una variable predictora es una combinación lineal de otras variables predictoras en el modelo.

La multicolinealidad no siempre es fácil de detectar, pero algunas señales de alerta incluyen coeficientes de regresión que cambian de signo o son significativamente diferentes de lo que se espera, y la reducción en la precisión de las estimaciones de los coeficientes.

Para evitar la multicolinealidad, se pueden tomar varias medidas.

Índice

ToggleEliminar las variables predictoras altamente correlacionadas

Es una de las formas más comunes de abordar la multicolinealidad en un modelo de regresión. Cuando dos o más variables predictoras están altamente correlacionadas, significa que proporcionan información similar al modelo y pueden dificultar la interpretación de los resultados y la estimación de los efectos individuales de cada variable.

Para identificar variables predictoras altamente correlacionadas, se puede calcular la matriz de correlación entre las variables predictoras en el conjunto de datos. Si se encuentra que dos o más variables predictoras tienen una correlación alta (generalmente, una correlación superior a 0,7 o 0,8), se debe considerar eliminar una de ellas del modelo.

La selección de qué variable predictoras eliminar puede hacerse utilizando diferentes criterios. Uno de los más comunes es eliminar la variable con el coeficiente de correlación más alto con otras variables predictoras. También se pueden utilizar técnicas de selección de variables, como la eliminación hacia atrás o la selección hacia adelante, que eliminan o agregan variables al modelo según la importancia y la correlación.

Es importante tener en cuenta que, al eliminar una variable del modelo, se está eliminando información del modelo y es posible que se esté perdiendo una parte importante de la relación con la variable respuesta. Por lo tanto, se debe tener cuidado al seleccionar qué variables eliminar y se deben considerar otros métodos para abordar la multicolinealidad si la eliminación de variables no es suficiente.

Eliminar las variables predictoras altamente correlacionadas es una de las formas más comunes de abordar la multicolinealidad en un modelo de regresión.

Se puede identificar las variables predictoras altamente correlacionadas utilizando la matriz de correlación y seleccionar qué variables eliminar utilizando diferentes criterios, como la correlación más alta o técnicas de selección de variables. Sin embargo, es importante tener en cuenta que, al eliminar una variable, se pierde información y puede ser necesario considerar otros métodos para abordar la multicolinealidad.

Combinar variables predictoras en una sola variable

Otra forma de abordar la multicolinealidad en un modelo de regresión es combinar varias variables predictoras altamente correlacionadas en una sola variable. Esto puede reducir la correlación entre las variables predictoras y mejorar la interpretación de los resultados.

Existen diferentes métodos para combinar variables predictoras, algunos de los cuales incluyen:

Media o suma de las variables predictoras: si dos o más variables predictoras están altamente correlacionadas y miden la misma cosa, se puede considerar tomar la media o la suma de las variables para crear una sola variable representativa. Por ejemplo, si se tienen las variables predictoras “edad del padre” y “edad de la madre”, que están altamente correlacionadas, se podría crear una sola variable que sea la media de ambas edades.

Componentes principales: los componentes principales son un método de reducción de dimensionalidad que se utiliza para combinar varias variables en un conjunto de componentes que capturan la mayor cantidad de variación en los datos. Los componentes principales se pueden utilizar como variables predictoras en un modelo de regresión. Este método es particularmente útil cuando hay varias variables predictoras altamente correlacionadas.

Análisis factorial: el análisis factorial es otro método de reducción de dimensionalidad que se utiliza para identificar relaciones latentes entre las variables predictoras. Las variables predictoras se agrupan en factores que son combinaciones lineales de las variables originales y se utilizan como variables predictoras en el modelo de regresión.

Es importante tener en cuenta que, al combinar variables predictoras en una sola variable, se pierde información y puede ser necesario considerar otras técnicas para abordar la multicolinealidad. Además, la combinación de variables predictoras debe estar justificada por la teoría subyacente del modelo y se deben realizar pruebas para asegurarse de que la nueva variable combinada tenga una relación significativa con la variable respuesta.

Selección de variables para identificar las variables más importantes y eliminar las menos importantes

La selección de variables es una técnica importante en el pre-procesamiento de datos que se utiliza para reducir la dimensionalidad y la complejidad de los datos antes de aplicar un modelo de aprendizaje automático. La selección de variables ayuda a mejorar la precisión y la eficiencia de los modelos al reducir la cantidad de datos y eliminar las variables irrelevantes o redundantes.

Hay varios métodos de selección de variables que se pueden utilizar en el pre-procesamiento de datos, algunos de los cuales incluyen:

Selección basada en modelos: se utiliza para seleccionar las variables que son importantes para un modelo en particular. Por ejemplo, se pueden utilizar técnicas de selección basadas en modelos como la regresión logística o los árboles de decisión para identificar las variables más importantes.

Selección de características univariadas: se utilizan técnicas estadísticas para identificar las variables más significativas de forma individual. Por ejemplo, se pueden utilizar pruebas de hipótesis como la prueba t de Student o la prueba F para identificar las variables más significativas.

Selección de características basadas en la importancia: se utilizan técnicas como la importancia de características basadas en árboles para identificar las variables más importantes en un conjunto de datos.

Es importante tener en cuenta que la selección de variables debe ser un proceso iterativo y debe basarse en la teoría subyacente del modelo y las características de los datos. Además, la selección de variables puede aumentar la precisión del modelo, pero también puede reducir su capacidad para generalizar a datos nuevos.

Otras opciones incluyen aumentar el tamaño de la muestra de datos para mejorar la precisión de las estimaciones, normalizar las variables predictoras para reducir la correlación, y utilizar técnicas de regresión más robustas que son menos sensibles a la multicolinealidad.

En resumen, la multicolinealidad es un problema en los modelos de regresión que ocurre cuando dos o más variables predictoras están altamente correlacionadas entre sí. Puede hacer que sea difícil determinar el efecto individual de cada variable y conducir a resultados inestables o incoherentes. Para evitar la multicolinealidad, se pueden tomar medidas como eliminar las variables altamente correlacionadas, combinarlas en una sola variable, utilizar técnicas de selección de variables y normalizar las variables predictoras.